Nadiren her şey göründüğü gibidir ve kuantum hesaplama dünyası bu tanıma çoğundan daha uygundur. İşleme yeteneklerimizde temel bir değişim olarak tanımlanan kuantum bilişimin gelişimi, son birkaç yılda inanılmaz bir hız kazandı. Henüz Association for Computing Machinery dergisinde yayınlanan bir araştırma makalesine göreilgili kuantum hesaplama (genellikle en güçlü klasik bilgisayarların bile etrafında dönen daireler olarak adlandırılan), yalnızca bir grafik kartını tahtından indirebilmesi için bazı alanlarda hala çığır açan keşifler gerektiriyor.

Kağıttaki en şaşırtıcı unsur bir dizi uygulamanın önceden düşünülenden daha uzun süre klasik hesaplama için (kuantum hesaplama yerine) daha uygun kalacağı sonucudur. Araştırmacılar bunun, ekibin araştırmalarının bir parçası olarak performansını simüle ettiği bir milyondan fazla fiziksel kubitte çalışan kuantum sistemleri için bile geçerli olduğunu söylüyor.

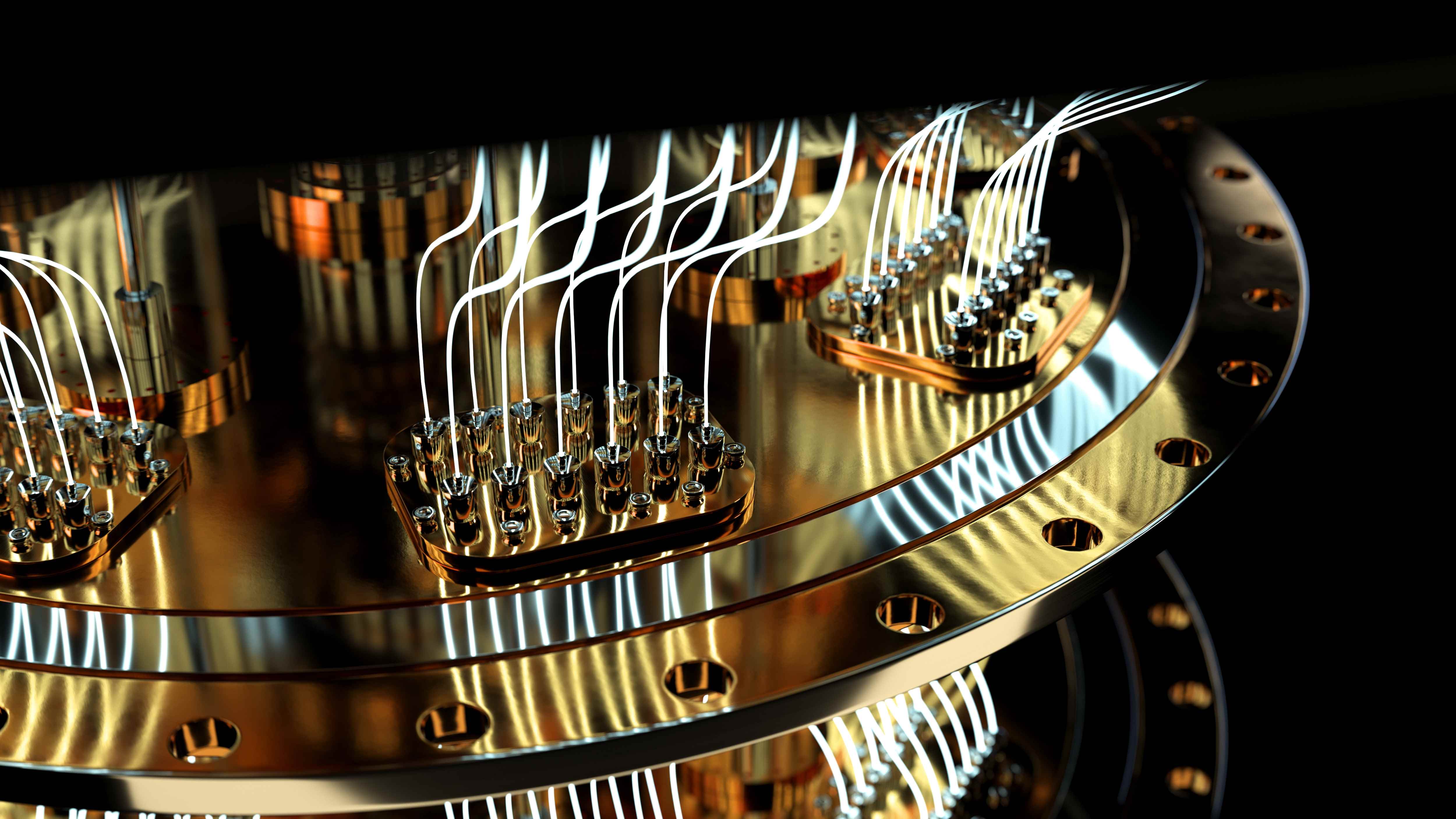

Günümüzün en iyi sistemi olan IBM’in Osprey’in hala “yalnızca” 433 kübitlik paketleri (IBM tarafından 2025 için vaat edilen 4.158 kübit sistem lansmanı ile) göz önünde bulundurulduğunda, bir milyon kübite doğru zaman ölçeği beklenenden daha fazla uzar.

Araştırmacılar, sorunun uygulamalarda veya iş yüklerinde olmadığını söylüyor – ilaç keşfi, malzeme bilimleri, programlama ve genel olarak optimizasyon sorunları hala kuantum hesaplamanın hedefinde. Sorun, kuantum bilgi işlem sistemlerinin kendilerinde – mimarilerinde ve bu uygulamaların bazılarının bir çözüm bulunmadan önce ihtiyaç duyduğu korkunç miktarda veriyi şu anda ve gelecekte alamamalarıyla ilgilidir. Bu basit bir G/Ç sorunu, NVMe SSD’ler norm haline gelmeden önce hepimizin bildiği, HDD’lerin CPU ve GPU’ları soldan ve sağdan sıkıştırdığı sorundan farklı değil: veriler ancak bu kadar hızlı beslenebilir.

Yine de ne kadar veri gönderildiği, hedefine ne kadar hızlı ulaştığı ve işlenmesinin ne kadar sürdüğü aynı denklemin unsurlarıdır. Bu durumda, denklem kuantum avantajı içindir – kuantum bilgisayarların klasik sistemler için mümkün olan her şeyin ötesinde bir performans sunduğu an. Ve öyle görünüyor ki, büyük veri kümelerinin işlenmesini gerektiren iş yüklerinde, kuantum bilgisayarların Nvidia’nın A100’ü gibi GPU’ları muhtemelen çok ama çok uzun bir süre boyunca çalıştırmasını izlemek zorunda kalacak.

Kuantum bilişim, küçük veriler üzerinde büyük bilgi işlem sorunlarını çözmekle yetinmek zorunda kalabilirken, klasik “büyük veri” sorunlarını işlemek gibi kaçınılmaz bir göreve sahip olacak – kuantum hesaplamaya son birkaç yıldır zemin kazandıran hibrit bir yaklaşım.

Bir blog gönderisine göre (yeni sekmede açılır) Araştırmaya katılan araştırmacılardan biri olan Microsoft’tan Matthias Troyer tarafından yazılan bu, ilaç tasarımı ve protein katlama gibi iş yüklerinin yanı sıra hava ve iklim tahmininin klasik sistemler için daha uygun olacağı anlamına gelirken, kimya ve malzeme bilimi mükemmel uyum sağlar. “büyük bilgi işlem, küçük veri” felsefesinin faturası.

Bu, kuantum hesaplamanın umutları için bir buz kovası meydan okuması gibi görünse de, Troyer durumun böyle olmadığını vurguladı: “Kuantum bilgisayarlar yalnızca kimya ve malzeme biliminden yararlansaydı, bu yeterli olurdu. bugün dünya kimya ve malzeme bilimi problemlerine indirgeniyor” dedi. “Daha iyi ve daha verimli elektrikli araçlar, daha iyi pil kimyaları bulmaya dayanır. Daha etkili ve hedefe yönelik kanser ilaçları, hesaplamalı biyokimyaya dayanır.”

Ancak araştırmacıların tezinde göz ardı edilmesi daha zor olan başka bir unsur daha var: Görünüşe göre mevcut kuantum hesaplama algoritmaları, istenen “kuantum avantajı” sonucunu garanti etmek için kendi başlarına yetersiz kalacak. Kuantum bir bilgisayarın sistem mühendisliği karmaşıklığından ziyade, burada basit bir performans sorunu var: genel olarak kuantum algoritmaları yeterince ivme sağlamıyor. Örneğin Grover’ın algoritması, klasik algoritmalara göre ikinci dereceden bir hızlanma sunar; ancak araştırmacılara göre bu neredeyse yeterli değil.

Makalede, “Bu düşünceler, kuantum uygulamaları arayışında yutturmacayı pratiklikten ayırmaya yardımcı olur ve algoritmik gelişmelere rehberlik edebilir.” “Analizimiz, topluluğun süper ikinci dereceden hızlara, ideal olarak üstel hız artışlarına odaklanması gerektiğini ve kişinin G/Ç darboğazlarını dikkatlice düşünmesi gerektiğini gösteriyor.”

Yani, evet, kuantum hesaplamaya doğru hala uzun bir yol var. Yine de dünyanın IBM’leri ve Microsoft’ları, bunu mümkün kılmak için araştırmalarını istikrarlı bir şekilde sürdürecekler. Bugün kuantum bilişimin karşı karşıya olduğu sorunların çoğu, klasik donanım geliştirirken karşılaştığımız sorunların aynısıdır — günümüzün CPU’ları, GPU’ları ve mimarileri çok daha erken ve daha etkili bir başlangıca sahipti. Ancak yine de kendi cesur yeni zaman çerçevesi içinde, kuantum bilişimin eninde sonunda yapacağı aynı tasarım ve performans yinelemelerinden geçmek zorunda kaldılar. Makalenin Microsoft, Amazon Web Services (AWS) ve Zürih’teki Ölçeklenebilir Paralel Bilişim Laboratuvarı’ndaki bilim adamları tarafından kaleme alınmış olması gerçeği – kuantum hesaplamanın geliştirilmesi ve başarısıyla ilgili tüm taraflar – bu hedefi daha da olası kılıyor.