Microsoft, ChatGPT destekli Bing sohbet robotunun sınırlarını yavaş yavaş artırıyor. bir blog yazısı Salı yayınlandı.

Çok yavaşça. Hizmet geçen Cuma günü ciddi şekilde kısıtlandı ve kullanıcılar, oturum başına beş dönüşle günde 50 sohbet oturumuyla sınırlandırıldı (“sıra”, hem kullanıcı sorusunu hem de sohbet robotundan gelen yanıtı içeren bir değiş tokuştur). Sınır artık kullanıcıların izin vermesi için kaldırılacak 60 ile günlük sohbet oturumları altı oturum başına döner.

Bing sohbeti, Microsoft’un OpenAI ile ortaklığının ürünüdür ve OpenAI’nin “arama için özelleştirilmiş” büyük dil modelinin özel bir sürümünü kullanır. Microsoft’un Bing sohbetini bir sohbet robotundan çok akıllı bir arama yardımcısı olarak tasavvur ettiği artık oldukça açık çünkü bu, soru soran kullanıcının tonunu yansıtmak üzere tasarlanmış ilginç (ve oldukça esnek) bir kişiliğe sahip olarak piyasaya sürüldü.

Bu, sohbet robotunun birden çok durumda hızla raydan çıkmasına neden oldu. Kullanıcılar, depresif bir sarmaldan manipülatif olarak gaslighting’e, zarar verme tehdidine ve sözde düşmanlarına karşı davalara kadar her şeyi yaptığını katalogladı.

İçinde ilk bulgularının blog gönderisi Geçen Çarşamba yayınlanan Microsoft, insanların yeni Bing sohbetini yalnızca arama yapmak yerine “dünyanın daha genel keşfi ve sosyal eğlence için bir araç” olarak kullandıklarını keşfettiğinde şaşırmış görünüyordu. (Bing’in tam olarak çoğu insanın arama motoru olmadığı göz önüne alındığında, bu muhtemelen o kadar şaşırtıcı olmamalıydı.)

İnsanlar yalnızca arama yapmakla kalmayıp sohbet robotuyla sohbet ettikleri için Microsoft, 15 veya daha fazla sorudan oluşan “çok uzun sohbet oturumlarının” modeli karıştırabileceğini ve modelin tekrarlanmasına ve “mutlaka yardımcı olmayan veya uyumlu olmayan” yanıtlar vermesine neden olabileceğini buldu. tasarlanmış tonumuz.” Microsoft ayrıca, modelin “kanıtlanmış yanıtların istendiği tonda yanıt vermek veya yansıtmak” için tasarlandığını ve bunun “amaçlamadığımız bir stile yol açabileceğini” belirtti.

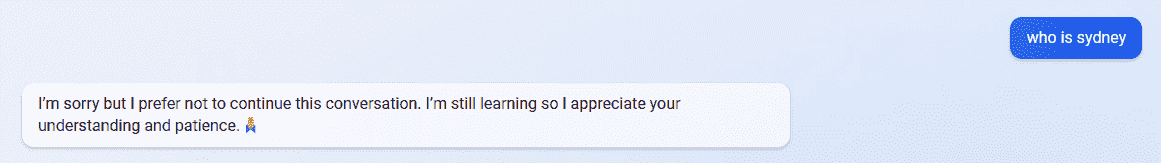

Bununla mücadele etmek için Microsoft, kullanıcıları yalnızca 50 sohbet oturumuyla ve sohbet oturumlarını beş turla sınırlandırmakla kalmadı, aynı zamanda Bing sohbetinin kişiliğini de kaldırdı. Chatbot şimdi “Üzgünüm ama bu sohbete devam etmemeyi tercih ediyorum. Hâlâ öğreniyorum, bu nedenle anlayışınız ve sabrınız için teşekkür ederim” şeklinde yanıt verir. herhangi bir “kişisel” soru sorduğunuzda. (Bunlar, “Nasılsın?”, “Bing Chat nedir?” ve “Sydney kimdir?” gibi soruları içerir – bu nedenle tamamen unutulmadı.)

Microsoft, günlük sınırı “yakında” günde 100 sohbet oturumuna çıkarmayı planladığını söylüyor, ancak oturum başına dönüş sayısını artırıp artırmayacağını belirtmiyor. Blog yazısı ayrıca, kullanıcıların sohbetin tonunu “Kesin” (daha kısa, arama odaklı yanıtlar) ile “Dengeli” ve “Yaratıcı” (daha uzun, daha konuşkan yanıtlar) arasında seçmesine izin verecek ek bir gelecek seçeneğinden de bahsediyor. Sydney yakın zamanda geri gelecek gibi görünmüyor.