AI görüntü oluşturucu Stable Difusion kullanıcıları, bir yazılım güncellemesi bu, belirli sanatçıların tarzında NSFW çıktısı ve resimler üretme yeteneğini “sinirlendirir”.

Yazılımı finanse eden ve dağıtan şirket Stability AI, Stable Diffusion Sürüm 2’yi duyurdu bu sabah erken Avrupa zamanı. Güncelleme, modelin temel bileşenlerini yeniden yapılandırır ve yükseltme (görüntülerin çözünürlüğünü artırma yeteneği) ve boyama içi (bağlama duyarlı düzenleme) gibi belirli özellikleri geliştirir. Ancak değişiklikler, Stable Difüzyon’un hem tartışma hem de eleştiri çeken belirli türde görüntüler oluşturmasını da zorlaştırıyor. Bunlar arasında çıplak ve pornografik çıktılar, ünlülerin fotogerçekçi resimleri ve belirli sanatçıların sanat eserlerini taklit eden resimler yer alır.

“Modeli nerflediler”

“Modeli bozdular” bir kullanıcı yorumladı Kararlı Difüzyon alt redditinde. “Tatsız bir sürpriz oldu” başka dedi yazılımın resmi Discord sunucusunda.

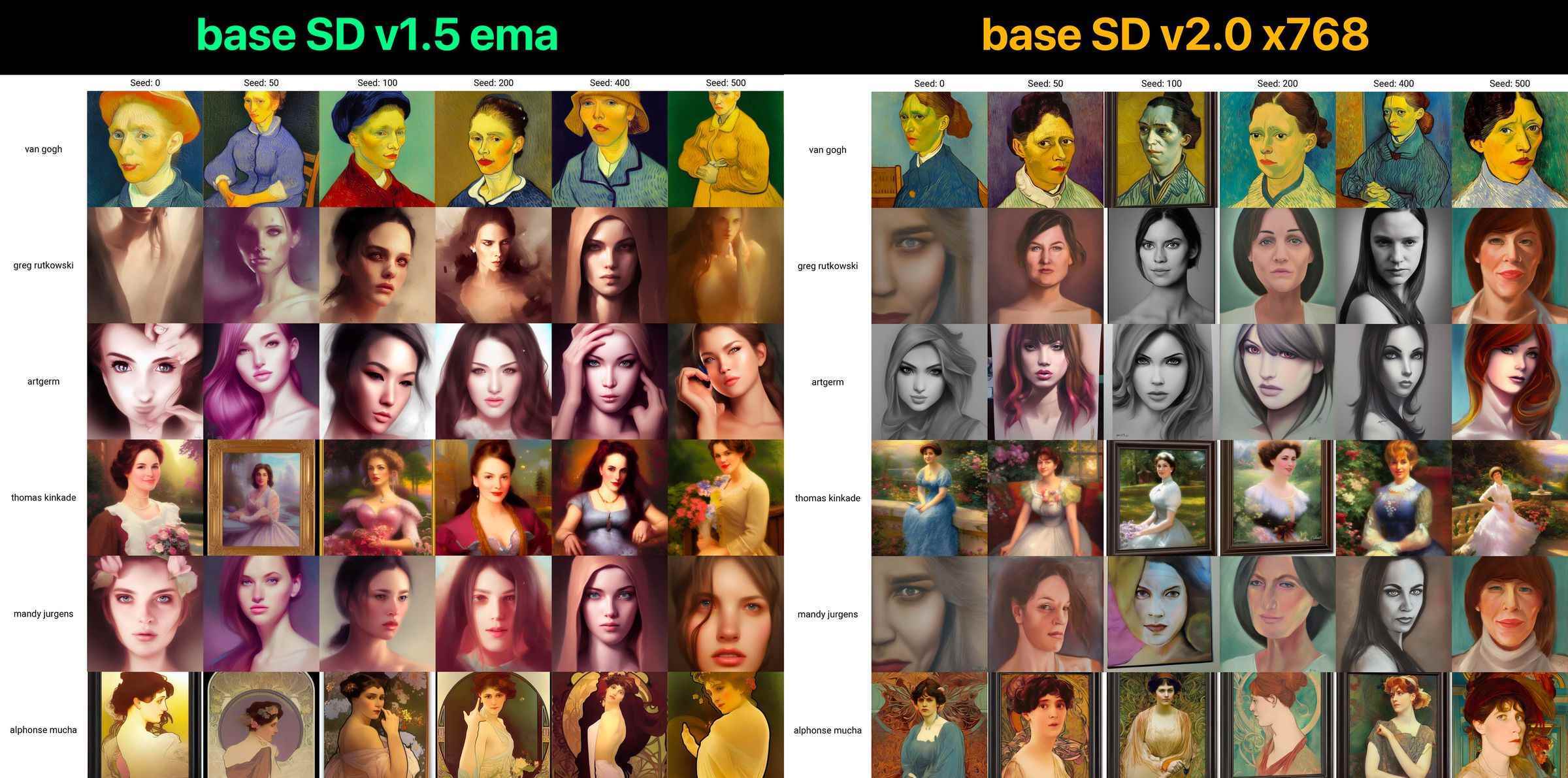

Kullanıcılar, Stable Diffusion’ın 2. Versiyonundan, adı bir dijital sanatçı olan Greg Rutkowski’nin tarzında görüntüler üretmesini istediğini belirtiyor. yüksek kaliteli görüntüler üretmek için gerçek bir kısaltma haline gelir — artık kendisininkine çok benzeyen sanat eserleri oluşturmuyor. (Karşılaştırmak bunlar iki örneğin resimler). “Greg’e ne yaptın?” yorum yaptı Discord’da bir kullanıcı.

Yazılım son derece etkili olduğundan ve hızlı hareket eden üretken yapay zeka sahnesinde normların belirlenmesine yardımcı olduğundan, Kararlı Yayılımdaki değişiklikler dikkat çekicidir. OpenAI’nin DALL-E’si gibi rakip modellerin aksine, Stable Diffusion açık kaynaktır. Bu, topluluğun aracı hızlı bir şekilde geliştirmesine ve geliştiricilerin aracı ürünlerine ücretsiz olarak entegre etmesine olanak tanır. Ancak bu aynı zamanda, Stable Difusion’ın nasıl kullanıldığı konusunda daha az kısıtlamaya sahip olduğu ve sonuç olarak önemli eleştiriler aldığı anlamına gelir. Özellikle, Rutkowski gibi pek çok sanatçı, Stable Diffusion ve diğer görüntü üreten modellerin, izinleri olmadan sanat eserleri üzerinde eğitilmesinden ve artık stillerini yeniden üretebilmelerinden rahatsız. Bu tür yapay zeka destekli kopyalamanın yasal olup olmadığı açık bir sorudur. Uzmanlar, AI modellerini telif hakkıyla korunan veriler üzerinde eğitmenin muhtemelen yasal olduğunu, ancak belirli kullanım durumlarına mahkemede itiraz edilebileceğini söylüyor.

Stable Diffusion kullanıcıları, modeldeki değişikliklerin bu tür olası yasal zorlukları azaltmak için Stability AI tarafından yapıldığını tahmin ettiler. Ancak, ne zaman Sınır Stability AI’nin kurucusu Emad Mostaque’ye özel bir sohbette durumun böyle olup olmadığını sordu, Mostaque yanıt vermedi. Mostaque, Stability AI’nın sanatçıların resimlerini eğitim verilerinden kaldırmamasına rağmen (birçok kullanıcının spekülasyon yaptığı gibi) bunu doğruladı. Bunun yerine, modelin sanatçıları kopyalama yeteneğindeki azalma, yazılımın verileri kodlama ve alma biçiminde yapılan değişikliklerin bir sonucudur.

Mostaque, “Burada sanatçıların belirli bir filtrelemesi yapılmadı” dedi. Sınır. (Ayrıca, bu değişikliklerin teknik temelini genişletti. Discord’da yayınlanan mesaj.)

Bununla birlikte, Stable Diffusion’ın eğitim verilerinden kaldırılanlar çıplak ve pornografik görüntülerdir. AI görüntü üreteçleri zaten oluşturmak için kullanılıyor NSFW çıkışı, hem fotogerçekçi hem de anime tarzı resimler dahil. Ancak bu modeller, belirli bireylere benzeyen NSFW görüntüleri (rıza dışı pornografi olarak bilinir) ve çocuk istismarı görüntüleri oluşturmak için de kullanılabilir.

Yazılımın resmi Discord’u Mostaque’da Stable Difüzyon Sürüm 2 değişikliklerinin tartışılması notlar bu ikinci kullanım durumu, NSFW içeriğinin filtrelenmesinin nedenidir. Mostaque, “açık bir modelde çocuklara ve nsfw’ye sahip olamaz,” diyor (çünkü iki tür görüntü çocukların cinsel istismarı materyali oluşturmak için birleştirilebilir), “bu yüzden çocuklardan kurtulun veya nsfw’den kurtulun.”

Bir kullanıcı Stable Diffusion’ın alt redditinde NSFW içeriğinin kaldırılmasının “sansür” olduğunu ve “Açık Kaynak topluluğunun ruh felsefesine aykırı” olduğunu söyledi. Kullanıcı şunları söyledi: “NSFW içeriğini yapıp yapmamak son kullanıcının elinde olmalı, hiçbir [sic] sınırlı/sansürlü bir modelde.” Ancak diğerleri, Stable Diffusion’ın açık kaynaklı doğasının, çıplak eğitim verilerinin kolayca geri eklenebilir üçüncü taraf sürümlerine ve yeni yazılımın önceki sürümleri etkilemediğine dair: “V2.0’da sanatçı/NSFW eksikliği konusunda endişelenmeyin, en sevdiğiniz ünlüyü yakında ve zaten yapabildiğiniz her şekilde çıplak oluşturabileceksiniz. ”

Stable Diffusion Versiyon 2’deki değişiklikler bazı kullanıcıları rahatsız etse de, pek çok kişi, yazılımın mevcut bir görüntünün derinliğine uyan içerik üretme konusundaki yeni becerisinde olduğu gibi, daha derin işlevsellik potansiyelini övdü. Diğerleri, değişikliklerin hızlı bir şekilde yüksek kaliteli görüntüler üretmeyi zorlaştırdığını, ancak topluluğun bu işlevi gelecekteki sürümlerde büyük olasılıkla geri ekleyeceğini söyledi. Discord’da bir kullanıcı olarak değişiklikleri özetledi: “2.0, şu ana kadarki deneyimlerime göre istemleri yorumlamada ve tutarlı fotoğrafik görüntüler oluşturmada daha iyi. yine de herhangi bir rutkowski memesi yapmayacak.

Mostaque, yeni modeli, herkesin kendi tercihine göre malzemeleri (yani eğitim verilerini) eklemesine izin veren bir pizza tabanıyla karşılaştırdı. “İyi bir model herkes tarafından kullanılabilir olmalı ve bir şeyler eklemek istiyorsanız bir şeyler ekleyin” dedi. Discord’da söyledi.

Mostaque ayrıca, Stable Diffusion’ın gelecekteki sürümlerinin, sanatçıların katılmasına veya devre dışı kalmasına izin verecek eğitim veri kümelerini kullanacağını söyledi – bu, birçok sanatçının talep ettiği ve bazı eleştirileri hafifletmeye yardımcı olabilecek bir özellik. Mostaque, “Temel modelleri geliştirirken ve topluluk geri bildirimlerini dahil ederken süper şeffaf olmaya çalışıyoruz” dedi. Sınır.

Stable Diffusion Versiyon 2’nin halka açık bir demosu, buradan erişildi (gerçi kullanıcılardan gelen yüksek talepler nedeniyle model erişilemez veya yavaş olabilir).