Dünyanın en iyi ve en kötü fikirlerinin çoğu gibi, MIT araştırmacılarının AI tarafından oluşturulan derin sahtekarlarla mücadele planı, içlerinden biri en sevdikleri haber dışı haber programını izlediğinde ortaya çıktı.

Star Wars: Shatterpoint Duyuru Fragmanı

02:27

VR’de Yapılması Gereken İlk Şeyler, Bölüm 3

dün 9:39

The Daily Show’un 25 Ekim bölümünde, OpenAI’nin Baş Teknoloji Sorumlusu Mira Murati ile Trevor Noah AI tarafından oluşturulan görüntüler hakkında konuştu. OpenAI’nin AI görüntü üreticisi DALL-E 2’yi büyük olasılıkla ayrıntılı olarak tartışabilmesine rağmen, çok derinlemesine bir röportaj değildi. Sonuçta, AI sanatı hakkında çok az veya hiçbir şey anlamayan tüm insanlar için ortaya çıktı. Yine de, birkaç düşünce parçası sundu. Noah, Murati’ye yapay zeka programlarının bizi hiçbir şeyin gerçek olmadığı ve her şeyin gerçek olduğu bir dünyaya götürmemesini sağlamanın bir yolu olup olmadığını sordu.

Geçen hafta, Massachusetts Teknoloji Enstitüsü’ndeki araştırmacılar bu soruyu cevaplamak istediklerini söylediler. Görünmez gürültü oluşturmak için bir görüntüdeki pikselleri esasen rahatsız etmek için veri zehirleme tekniklerini kullanabilen nispeten basit bir program tasarladılar ve AI sanat oluşturucularını gerçekçi bir şekilde üretemez hale getirdiler. derin sahteler besledikleri fotoğraflara göre. MIT’de bilgisayar profesörü olan Aleksander Madry, programı geliştirmek için araştırmacılardan oluşan bir ekiple birlikte çalıştı ve sonuçlarını Twitter’da yayınladı. laboratuvarın blogu.

Noah’ın Daily Show komedyeni Michael Kosta ile fotoğraflarını kullanarak, görüntüdeki bu algılanamayan gürültünün, bir difüzyon modeli AI görüntü oluşturucunun orijinal şablonu kullanarak yeni bir fotoğraf oluşturmasını nasıl bozduğunu gösterdiler. Araştırmacılar, internete bir görüntü yüklemeyi planlayan herkesin, fotoğraflarını programları aracılığıyla çalıştırabileceğini ve temelde onu AI görüntü oluşturucularına bağışık hale getirebileceğini öne sürdüler.

G/O Media komisyon alabilir

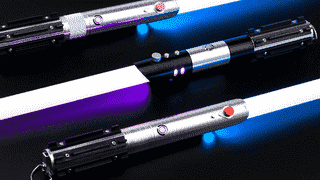

*ışın kılıcı vızıltısı*

SabresPro

Her şeyiyle Star Wars hayranı için.

Neopikseller tarafından desteklenen bu ışın kılıçları, ayarlanabilir renklere, etkileşimli seslere ve düello sırasında değişen animasyon efektlerine izin veren bıçak şeklinin içinde çalışan LED şeritler.

VardıÇalışmaları makine öğrenimi modelleri etrafında dönen MIT’de doktora öğrencisi olan Salman, Gizmodo’ya bir telefon görüşmesinde, geliştirmesine yardım ettiği sistemin bir fotoğrafa gürültü eklemesinin yalnızca birkaç saniye sürdüğünü söyledi. Daha yüksek çözünürlüklü görüntülerin daha da iyi çalıştığını söyledi, çünkü bunlar çok ufak bir şekilde bozulabilecek daha fazla piksel içeriyor.

Google, Imagen adlı kendi AI görüntü oluşturucusunu yaratıyor, ancak çok az kişi sistemlerini adım adım ilerletebildi. Şirket ayrıca bir üretken AI video sistemi. Salman, sistemlerini video üzerinde test etmediklerini, ancak teoride yine de çalışması gerektiğini söyledi, ancak MIT’nin programı, bir videonun her karesini ayrı ayrı taklit etmek zorunda kalacaktı; bu, herhangi bir videodan daha uzun herhangi bir video için on binlerce kare olabilir. birkaç dakika.

Veri Zehirlenmesi, Ölçekli Yapay Zeka Jeneratörlerine Uygulanabilir mi?

Salman, şirketlerin, hatta AI modellerini oluşturanların bile, yüklenen görüntülerin AI modellerine karşı aşılandığını onaylayabileceği bir gelecek hayal edebileceğini söyledi. Elbette bu, LAION gibi açık kaynak kitaplığına halihazırda yüklenmiş milyonlarca görüntü için pek iyi bir haber değil, ancak gelecekte yüklenen herhangi bir görüntü için potansiyel olarak bir fark yaratabilir.

Madry ayrıca Gizmodo’ya telefonla, bu sistemin, veri zehirlenmelerinin birçok testinde işe yaramasına rağmen, herhangi bir ürün sürümünden çok bir kavram kanıtı olduğunu söyledi. Araştırmacıların programı, derin sahtekarlıkları gerçekleşmeden önce yenmenin yolları olduğunu kanıtlıyor.

Şirketlerin bu teknolojiyi tanıması ve kurcalamaya karşı daha dayanıklı hale getirmek için kendi sistemlerine uygulaması gerektiğini söyledi. Moreso, şirketlerin difüzyon modellerinin veya başka herhangi bir AI görüntü üreticisinin gelecekteki yorumlarının gürültüyü görmezden gelemeyeceğinden ve yeni derin sahteler oluşturmayacağından emin olmaları gerekecek.

Madry, “İlerlemek için gerçekten olması gereken şey, difüzyon modelleri geliştiren tüm şirketlerin sağlıklı, sağlam bağışıklama için yetenek sağlamasıdır.” Dedi.

Makine öğrenimi alanındaki diğer uzmanlar, MIT araştırmacılarını eleştirecek bazı noktalar buldu.

İsviçre’de ETH Zürih’te bilgisayar bilimi profesörü olan Florian Tramer, tweetlendi asıl zorluğun, bir görüntü ile bir deepfake yaratmaya yönelik gelecekteki tüm girişimleri kandırmaya çalışmanızdır. Tramer, bir kitabın ortak yazarıydı. 2021 kağıt Uluslararası Öğrenme Temsilleri Konferansı tarafından yayınlanan ve temel olarak, MIT sisteminin görüntü gürültüsüyle yaptığı gibi veri zehirlenmesinin, gelecekteki sistemlerin bunun etrafında yollar bulmasını engellemeyeceğini tespit etti. Dahası, bu veri zehirlenme sistemlerini oluşturmak, ticari AI görüntü oluşturucuları ile derin sahtekarlıkları önlemeye çalışanlar arasında bir “silahlanma yarışı” yaratacaktır.

AI tabanlı gözetim ile başa çıkmak için tasarlanmış başka veri zehirleme programları olmuştur, örneğin: Fawkes (evet, 5 Kasım gibi), Chicago Üniversitesi’ndeki araştırmacılar tarafından geliştirildi. Fawkes ayrıca görüntülerdeki pikselleri, Clearview gibi şirketlerin doğru yüz tanıma elde etmesini engelleyecek şekilde bozar. Avustralya’daki Melbourne Üniversitesi’nden ve Çin’deki Pekin Üniversitesi’nden diğer araştırmacılar da “öğrenilemez örnekler” AI görüntü oluşturucuların kullanamayacağı.

Sorun, Fawkes geliştiricisi Emily Wenger’in bir röportajda belirttiği gibi. MIT Teknoloji İncelemesiMicrosoft Azure gibi programlar Fawkes’a karşı kazanmayı başardı ve düşmanca tekniklerine rağmen yüzleri tespit etti.

Kanada, Onatrio’daki Waterloo Üniversitesi’nde bilgisayar bilimi profesörü olan Gautam Kamath, bir Zoom röportajında Gizmodo’ya, yapay zeka modelleri oluşturmaya çalışanlar ile onları yenmenin yollarını bulanlar arasındaki “kedi fare oyunu”nda, üretim yapan insanların olduğunu söyledi. Yeni AI sistemleri, bir kez internette bir görüntü olduğunda, asla gerçekten kaybolmadığından, üstünlüğe sahip görünüyor. Bu nedenle, bir AI sistemi, derin sahtecilikten alıkoyma girişimlerini atlamayı başarırsa, onu düzeltmenin gerçek bir yolu yoktur.

Kamath, “Muhtemelen olmasa da, gelecekte o belirli görüntüye koyduğunuz her türlü savunmadan kaçınabilmemiz mümkün,” dedi. “Ve bir kez orada olduğunda, onu geri alamazsın.”

tabii ki var derin sahte videoları algılayabilen bazı AI sistemlerive bunun yolları var küçük tutarsızlıkları tespit etmek için insanları eğitin Bu, bir videonun sahte olduğunu gösterir. Soru şu: Bir fotoğrafın veya videonun manipüle edilip edilmediğini ne insanın ne de makinenin ayırt edemediği bir zaman gelecek mi?

En Büyük AI Jeneratör Şirketleri Nedir?

Madry ve Salman için cevap, AI şirketlerinin top oynamasını sağlamak. Madry, önerilen sistemlerini kolaylaştırmakla ilgilenip ilgilenmeyeceklerini görmek için bazı büyük AI üreticisi şirketlerle temasa geçmek istediklerini söyledi, ancak elbette hala ilk günlerde ve MIT ekibi hala genel bir API üzerinde çalışıyor. kullanıcıların kendi fotoğraflarını aşılamasına izin verin (kod mevcut burada).

Bu şekilde, hepsi AI görüntü platformlarını yapan insanlara bağlıdır. OpenAI’den Murati Ekim’deki bölümde Noah’a sistemlerinde “bazı korkuluklar” olduğunu söylerken, dahası insanların halka açık rakamlara dayalı görüntüler oluşturmasına izin vermediklerini iddia ediyor (ki bu sosyal medya çağında neredeyse herkesin konuştuğu oldukça belirsiz bir terimdir). halka açık bir yüzü vardır). Ekip ayrıca, sistemin şiddet içeren veya cinsel içerikli görüntüler içeren görüntüler oluşturmasını kısıtlayacak daha fazla filtre üzerinde çalışıyor.

Eylül ayında OpenAI duyurdu kullanıcılar bir kez daha insan yüzlerini yükleyebilir ancak kullanıcıların şiddet içeren veya cinsel içerikli ortamlarda yüzlerini göstermelerini engellemek için yollar oluşturduklarını iddia ettiler. Ayrıca, kullanıcılardan rızaları olmadan insanların resimlerini yüklememelerini istedi, ancak genel internetten parmaklarını çarpmadan vaatlerde bulunmalarını istemek çok fazla.

Ancak bu, diğer AI üreticilerinin ve onları yapanların, kullanıcılarının ürettiği içeriği denetleme konusunda oyun gibi olduğu anlamına gelmez. Stable Diffusion’ın arkasındaki şirket olan Stability AI, insanların kendi sistemini kullanarak porno veya türev sanat eserleri oluşturmasını engelleyen herhangi bir engel koyma konusunda çok daha isteksiz olduklarını gösterdi. OpenAI, ahem, sistemlerinin oluşturduğu görüntülerde önyargı göstermesini engellemeye çalışmak konusunda açık olsa da, StabilityAI güzel anne tuttu.

Stability AI’nin CEO’su Emad Mostaque, hükümet veya kurumsal etkisi olmayan bir sistemi savundu ve şimdiye kadar geri savaştı AI modeline daha fazla kısıtlama getirme çağrılarına karşı. O sahip görüntü üretimine inandığını söyledi “bir yıl içinde çözülecek” ve kullanıcıların “hayal edebileceğiniz her şeyi” yaratmalarına olanak tanıyacak. Tabii ki, bu sadece abartı konuşuyor, ancak Mostaque’ın teknolojinin kendisini daha da ileriye götürdüğünü görmekten geri adım atmaya istekli olmadığını gösteriyor.

Yine de, MIT araştırmacıları sabit kalıyor.

Madry, “Bence bu tür bir teknolojiye kolayca erişilebildiğinde dünyanın ne olduğu hakkında çok rahatsız edici sorular var ve yine, zaten kolayca erişilebilir ve kullanımı daha da kolay olacak” dedi. “Gerçekten çok mutluyuz ve artık bu konuda fikir birliğine vararak bir şeyler yapabileceğimiz için gerçekten heyecanlıyız.”