Resim: Google

Google mobil uygulamasını açtı AI Test Mutfağı konuşma modeli gibi yapay zekadaki en son gelişmelerle herkesin sınırlı uygulamalı deneyim kazanmasını sağlamak MDA (Diyalog Uygulamaları için Dil Modeli).

Google, LaMDA’nın ikinci sürümünün yanı sıra Mayıs ayında AI Test Kitchen’ı duyurdu ve şimdi halkın insan-bilgisayar etkileşiminin geleceği olacağına inandıkları bölümleri test etmesine izin veriyor.

Google CEO’su Sunday Pichai, AI Test Kitchen’ın “size LaMDA’nın elinizde olmasının nasıl bir şey olabileceği hakkında bir fikir vermeyi amaçladığını” söyledi.

Başlangıçta, Amerika Birleşik Devletleri’ndeki küçük gruplar için erişilebilir olacak. Android uygulaması şu anda mevcut, iOS uygulamasının ise “önümüzdeki haftalarda” olması bekleniyor.

Uyarı: uygunsuz içerik filtrelenebilir

Kayıt olurken, kullanıcı “Bu demolarla etkileşimlerime kendim veya başkaları hakkında kişisel bilgileri dahil etmeyeceğim” dahil olmak üzere belirli koşulları kabul etmelidir.

Yakın zamanda AI sohbet robotu modeli BlenderBot 3’ü herkese açık olarak önizleyen Meta gibi, Google da LaMDA’nın ilk sürümlerinin “yanlış veya uygunsuz içerik gösterebileceği” konusunda uyarıyor. Meta, BlenderBot 3’ü açarken, sohbet robotunun bir robot olduğunu “unutabileceği” ve “gurur duymadığımız şeyler söyleyebileceği” konusunda uyardı.

Her iki şirket de, Microsoft’un sohbet botu Tay’ın 2016’da halkın onu kötü yorumlarıyla beslemesinden sonra yaptığı gibi, AI’larının zaman zaman politik olarak yanlış olarak görülebileceğini kabul ediyor. Ve Meta gibi Google, LaMDA’nın yanlış ve rahatsız edici cevaplar vermesini önlemek için “temel güvenlik geliştirmelerinden” geçtiğini söylüyor.

Ancak Meta’dan farklı olarak Google, halkın onunla nasıl iletişim kurabileceğine sınırlar koyarak daha kısıtlayıcı bir yaklaşım benimsiyor gibi görünüyor. Şimdiye kadar Google, LaMDA’yı Google çalışanlarına gösterdi. Bunu halka açmak, Google’ın yanıtların kalitesini iyileştirme hızını hızlandırmasına olanak sağlayabilir.

diyalog simülasyonu

Google, AI Test Kitchen’ı bir dizi demo olarak yayınladı. İlki, “Hayal edin”, bir yeri adlandırmanıza izin verir, ardından AI size “hayal gücünüzü keşfetmeniz” için yollar sunar.

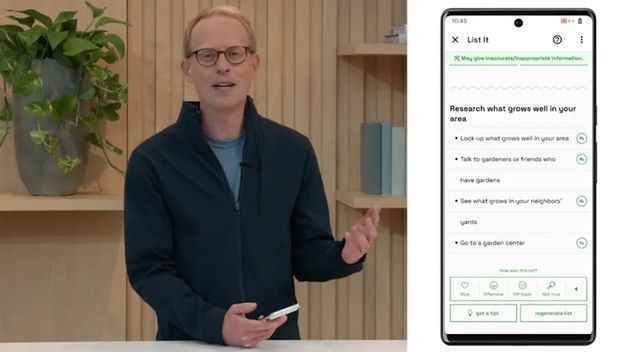

İkinci demo, “List it”, LaMDA’nın daha sonra yararlı alt görevler listesine ayırmaya çalıştığı “bir hedefi veya konuyu paylaşmanıza” izin verir.

Üçüncü demo, “Konuş (Köpekler baskısı)”, köpek sorularıyla sınırlı olmasına rağmen en özgür test gibi görünüyor: “Köpekler hakkında ve sadece köpekler hakkında, LaMDA’nın kalma yeteneğini araştıran eğlenceli ve açık bir konuşma yapabilirsiniz. Konudan sapmaya çalışsanız bile konuyla ilgili,” diye açıklıyor Google.

LaMDA ve BlenderBot 3, bir bilgisayar ve insanlar arasındaki diyalogu simüle eden dil modellerinde en iyi performansı arar.

LaMDA, 137 milyarlık büyük bir parametre dili modeliyken, Meta’nın BlenderBot 3’ü “internet erişimi ve uzun bellek ile açık bir alanda sohbet edebilen 175 milyar parametreli diyalog modelidir”.

Google’ın dahili testleri, AI güvenliğini iyileştirmeye odaklandı. Google, modelde yeni kusurlar bulmak için çapraz testler yaptığını ve “ek zararlı, ancak ince sonuçları ortaya çıkaran” saldırı uzmanlarından oluşan “kırmızı bir ekip” işe aldığını söyledi. Google Research’ten Tris Warkentin ve Google Labs’den Josh Woodward’a göre.

Çift taraflı halka açık maruz kalma

Google, güvenliği sağlamak ve yapay zekasının utanç verici şeyler söylemesini engellemek isterken, Google, tahmin edemediği insan konuşmasını deneyimlemek için onu vahşi hale getirmekten de yararlanabilir. . Tam bir ikilem.

Google, Microsoft’tan Tay’ın halka maruz kaldığında maruz kaldığı çeşitli sınırlamalara dikkat çekiyor. “Model, kimlik terimlerinin arkasındaki amacı yanlış anlayabilir ve bazen kullanıldığında iyi huylu ve olumsuz istemler arasında ayrım yapmakta zorlandığı için bir yanıt üretemeyebilir. Ayrıca, eğitim verilerindeki önyargılara dayalı olarak zararlı veya toksik tepkiler üretebilir ve insanları cinsiyetlerine veya kültürel geçmişlerine göre klişeleştiren ve yanlış temsil eden tepkiler üretebilir. Bu ve diğer alanlar aktif olarak araştırılıyor” diyor Tris Warkentin ve Josh Woodward.

Google, şimdiye kadar eklediği korumaların AI’sını daha güvenli hale getirdiğini, ancak riskleri ortadan kaldırmadığını söylüyor. Korumalar, “kullanıcıların bilerek müstehcen, nefret dolu veya saldırgan, şiddet içeren, tehlikeli veya yasa dışı içerik oluşturmasını yasaklayan veya kişisel bilgileri ifşa eden” kurallarını ihlal eden kelimeleri veya ifadeleri filtrelemeyi içerir. »

Öte yandan, kullanıcılar Google’ın LaMDA demosunu yaparken söylenen her şeyi silmesini beklememelidir.

“Belirli bir demoyu kullanırken verilerimi silebileceğim, ancak demodan ayrıldıktan sonra verilerim, Google’ın kimin sağladığını söyleyemeyeceği ve artık yanıt veremeyeceği şekilde saklanacak. herhangi bir silme talebine”, rıza formunu okuyabilir miyiz.

Kaynak : ZDNet.com