AI dünyası hala, DALL-E 2’nin hemen hemen her şeyi çizme/boyama/hayal etme yeteneği olan inanılmaz cesaret gösterisiyle nasıl başa çıkacağını bulmaya çalışıyor… ancak böyle bir şey üzerinde çalışan tek kişi OpenAI değil. Google Research, üzerinde çalıştığı benzer bir modeli duyurmak için acele etti ve bunun daha da iyi olduğunu iddia ediyor.

görüntü (anladın mı?) büyük dönüştürücü dil modelleri üzerine inşa edilmiş metinden görüntüye difüzyon tabanlı bir jeneratördür… tamam, hadi yavaşlayalım ve bu kadar hızlı paketi açalım.

Metinden görüntüye modeller, “bisiklette bir köpek” gibi metin girdileri alır ve buna karşılık gelen bir görüntü üretir; bu, yıllardır yapılan ancak son zamanlarda kalite ve erişilebilirlik açısından büyük sıçramalar gören bir şey.

Bunun bir kısmı, temel olarak saf bir gürültü görüntüsüyle başlayan ve model onu bisikletteki bir köpek gibi gösteremeyeceğini düşünene kadar yavaş yavaş iyileştiren difüzyon tekniklerini kullanıyor. Bu, tepeden tırnağa jeneratörler üzerinde, ilk tahminde komik bir şekilde yanlış yapabilen ve diğerlerini kolayca yoldan çıkarabilecek bir gelişmeydi.

Diğer kısım, teknik yönlerine burada girmeyeceğim (ve yapamayacağım) dönüştürücü yaklaşımını kullanan büyük dil modelleri aracılığıyla geliştirilmiş dil anlayışıdır, ancak bu ve diğer birkaç yeni gelişme, aşağıdakiler gibi ikna edici dil modellerine yol açmıştır. GPT-3 ve diğerleri.

Resim Kredisi: Google Araştırması

Imagen, küçük (64×64 piksel) bir görüntü oluşturarak başlar ve ardından 1024×1024’e getirmek için üzerinde iki “süper çözünürlük” geçişi yapar. Bununla birlikte, AI süper çözünürlüğü orijinali temel alarak daha küçük görüntüyle uyum içinde yeni ayrıntılar oluşturduğundan, bu normal yükseltme gibi değildir.

Örneğin, bisiklete binen bir köpeğiniz olduğunu ve ilk resimde köpeğin gözünün 3 piksel olduğunu varsayalım. İfade için çok fazla yer yok! Ama ikinci resimde, 12 piksel genişliğinde. Bunun için gereken detay nereden geliyor? Yapay zeka bir köpeğin gözünün neye benzediğini biliyor, bu yüzden çizdikçe daha fazla ayrıntı üretiyor. Sonra bu, göz tekrar yapıldığında, ancak 48 pikselde tekrar olur. Ancak hiçbir noktada yapay zeka, köpek gözü pikseli ne olursa olsun 48’i kendi sihirli çantasından çıkarmak zorunda kalmadı. Pek çok sanatçı gibi, kaba bir eskiz eşdeğeri ile başladı, bir çalışmada doldurdu, sonra gerçekten son tuval üzerinde şehre gitti.

Bu eşi benzeri görülmemiş bir durum ve aslında yapay zeka modelleriyle çalışan sanatçılar, yapay zekanın tek seferde kaldırabileceğinden çok daha büyük parçalar oluşturmak için bu tekniği zaten kullanıyor. Bir tuvali birkaç parçaya bölerseniz ve hepsini ayrı ayrı süper çözünürlüklü hale getirirseniz, sonuçta çok daha büyük ve daha girift ayrıntılı bir şey elde edersiniz; hatta defalarca yapabilirsiniz. ilginç bir örnek tanıdığım bir sanatçıdan:

Google’ın araştırmacılarının Imagen ile iddia ettiği ilerlemeler birkaç tane. Mevcut metin modellerinin metin kodlama kısmı için kullanılabileceğini ve kalitelerinin görsel doğruluğu artırmaktan daha önemli olduğunu söylüyorlar. Bu sezgisel olarak mantıklıdır, çünkü saçmalığın ayrıntılı bir resmi, tam olarak istediğiniz şeyin biraz daha az ayrıntılı bir resminden kesinlikle daha kötüdür.

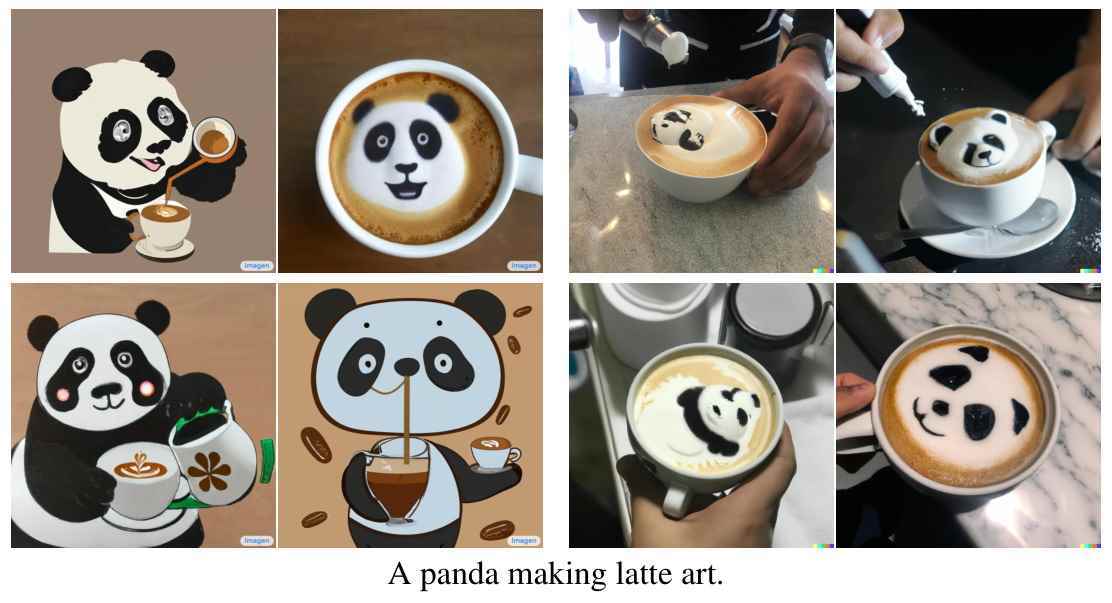

Örneğin, kağıt Imagen’i tanımlayarak, bunun sonuçlarını ve DALL-E 2’yi “latte sanatı yapan bir panda” yaparak karşılaştırıyorlar. İkincisinin tüm resimlerinde, bir pandanın latte sanatı; Imagen’lerin çoğunda sanatı yapan bir panda. (İkisi de ata binen bir astronot yapmayı başaramadı, tüm denemelerde tam tersini gösterdi. Devam eden bir çalışma.)

Resim Kredisi: Google Araştırması

Google’ın testlerinde Imagen, hem doğruluk hem de aslına uygunluk açısından insan değerlendirmesi testlerinde öne çıktı. Bu açıkçası oldukça öznel, ancak bugüne kadar her şeyin önünde büyük bir sıçrama olarak kabul edilen DALL-E 2’nin algılanan kalitesiyle eşleşmek bile oldukça etkileyici. Sadece şunu ekleyeceğim, oldukça iyi olsa da, bu görüntülerin hiçbiri (herhangi bir jeneratörden), insanlar oluşturulduklarını fark etmeden veya ciddi şüpheler duymadan önce üstünkörü bir incelemeden daha fazla dayanamayacak.

Yine de OpenAI, birkaç yönden Google’ın bir veya iki adım önündedir. DALL-E 2 bir araştırma makalesinden daha fazlasıdır, tıpkı selefi ve GPT-2 ve 3’ü kullandıkları gibi, onu kullanan kişilerin olduğu özel bir betadır. İronik olarak, adında “open” olan şirket metnini üretmeye odaklanmıştır. -Görüntüye araştırma, inanılmaz karlı internet devi henüz denemedi.

Bu, DALL-E 2 araştırmacılarının eğitim veri kümesini önceden düzenlemek ve kendi yönergelerini ihlal edebilecek her türlü içeriği kaldırmak için yaptığı seçimden çok daha açık. Model denerse NSFW bir şey yapamazdı. Ancak Google’ın ekibi, uygunsuz materyal içerdiği bilinen bazı büyük veri kümelerini kullandı. Araştırmacılar, Imagen sitesindeki “Sınırlamalar ve Toplumsal Etki”yi açıklayan anlayışlı bir bölümde şunları yazıyor:

Metinden görüntüye modellerin aşağı yönlü uygulamaları çeşitlidir ve toplumu karmaşık şekillerde etkileyebilir. Kötüye kullanımın olası riskleri, kod ve demoların sorumlu açık kaynak kullanımına ilişkin endişeleri artırmaktadır. Şu anda kod veya genel bir demo yayınlamamaya karar verdik.

Metinden görüntüye modellerin veri gereksinimleri, araştırmacıları büyük ölçüde büyük, çoğunlukla düzenlenmemiş, web-kazınmış veri kümelerine güvenmeye yöneltmiştir. Bu yaklaşım son yıllarda hızlı algoritmik ilerlemeleri mümkün kılmış olsa da, bu nitelikteki veri kümeleri genellikle sosyal klişeleri, baskıcı bakış açılarını ve marjinalleştirilmiş kimlik gruplarına yönelik aşağılayıcı veya başka türlü zararlı çağrışımları yansıtır. Eğitim verilerimizin bir alt kümesi, pornografik görüntüler ve zehirli dil gibi gürültü ve istenmeyen içeriği kaldırmak için filtrelenirken, pornografik görüntüler, ırkçı hakaretler ve çok çeşitli uygunsuz içerik içerdiği bilinen LAION-400M veri kümesini de kullandık. zararlı sosyal klişeler. Imagen, kürlenmemiş web ölçeğindeki veriler üzerinde eğitilmiş metin kodlayıcılara dayanır ve bu nedenle büyük dil modellerinin sosyal önyargılarını ve sınırlamalarını devralır. Bu nedenle, Imagen’in daha fazla güvenlik önlemi olmadan, Imagen’i kamunun kullanımına açmama kararımıza rehberlik eden zararlı stereotipler ve temsiller kodlaması riski vardır.

Bazıları, Google’ın yapay zekasının politik olarak yeterince doğru olmayabileceğinden korktuğunu söyleyerek buna sazan olsa da, bu acımasız ve dar görüşlü bir görüş. Bir yapay zeka modeli, yalnızca üzerinde eğitim aldığı veriler kadar iyidir ve her ekip, bu kazıyıcıların milyonlarca görüntüyü veya milyarlarca görüntüyü bir araya getirirken aldıkları gerçekten korkunç şeyleri kaldırmak için harcayabileceği zaman ve çabayı harcayamaz. kelime veri kümeleri.

Bu tür önyargıların, sistemlerin nasıl çalıştığını ortaya çıkaran ve bu ve diğer sınırlamaları belirlemek için sınırsız bir test alanı sağlayan araştırma süreci sırasında ortaya çıkması amaçlanmıştır. Herhangi bir çocuğun çizebileceği saç stilleri olan bir yapay zekanın Siyah insanlar arasında yaygın olan saç stillerini çizemeyeceğini başka nasıl bilebiliriz? Veya çalışma ortamları hakkında hikayeler yazması istendiğinde, yapay zeka her zaman patronu bir erkek yapar mı? Bu durumlarda, bir AI modeli kusursuz ve tasarlandığı gibi çalışıyor – eğitim aldığı medyaya yayılan önyargıları başarıyla öğrendi. İnsanlardan farklı değil!

Ancak sistemik önyargıyı unutmak birçok insan için ömür boyu sürecek bir proje olsa da, bir yapay zekanın işi daha kolay ve yaratıcıları, ilk etapta kötü davranmasına neden olan içeriği kaldırabilir. Belki bir gün 50’li yıllardan kalma ırkçı, cinsiyetçi bir uzman tarzında yazmak için bir yapay zekaya ihtiyaç duyulacak, ancak şimdilik bu verileri dahil etmenin faydaları küçük ve riskleri büyük.

Her halükarda, Imagen, diğerleri gibi, hala açıkça deney aşamasındadır, kesinlikle insan denetimli bir tarzdan başka bir şeyde kullanılmaya hazır değildir. Google, yeteneklerini daha erişilebilir hale getirmeye başladığında, nasıl ve neden çalıştığı hakkında daha fazla şey öğreneceğimize eminim.