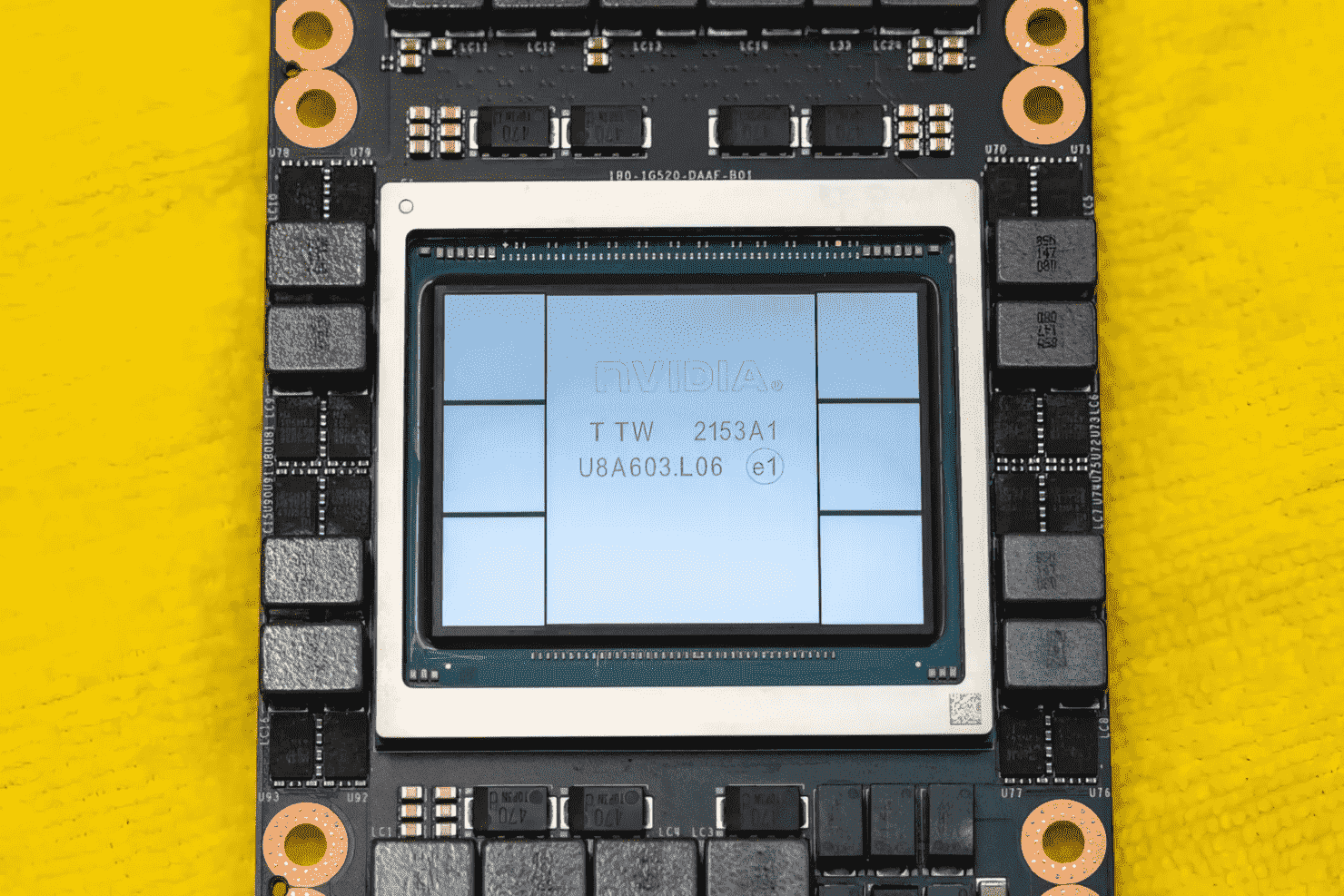

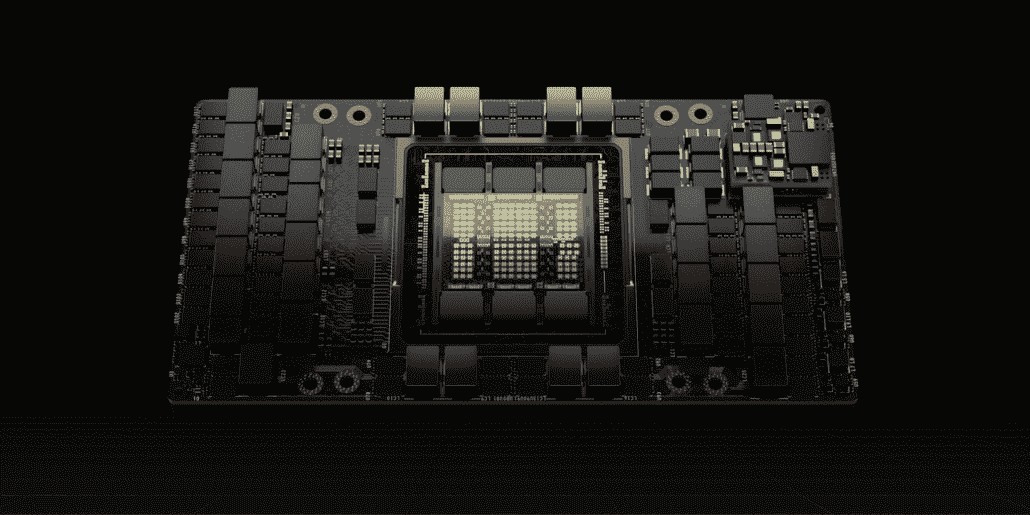

NVIDIA’nın amiral gemisi Datacenter GPU’su Hopper H100, tüm ihtişamıyla resmedildi. (Resim Kredisi: CNET)

NVIDIA, GTC 2022’de, yeni nesil veri merkezleri için tasarlanmış bir bilgi işlem güç merkezi olan Hopper H100 GPU’yu tanıttı. Bu güçlü çipten bahsetmeyeli uzun zaman oldu ama görünüşe göre NVIDIA medyayı seçmek için amiral gemisi çipinin yakından görüntüsünü vermiş.

NVIDIA Hopper H100 GPU: 4nm ve HBM3 Teknolojisine Sahip İlk Yüksek Çözünürlüklü Resimler Elde Ediyor

CNET sadece H100 GPU’nun birleştiği grafik kartını değil, aynı zamanda H100 yongasının kendisini de ele geçirmeyi başardı. H100 GPU, en son 4nm teknolojisiyle paketlenmiş olarak gelen ve son teknoloji HBM3 bellek teknolojisiyle birlikte 80 Milyar transistör içeren bir canavar çiptir. Teknoloji çıkışına göre, H100, Hopper H100 GPU’yu 6 yığınlı bir HBM3 tasarımıyla birleştirmek için TSMC’nin CoWoS teknolojisini kullanan 30’dan fazla güçlü VRM’ye ve devasa bir entegre aracıya sahip PG520 PCB kartı üzerine inşa edilmiştir.

Resimdeki NVIDIA Hopper H100 GPU (Resim Kredisi: CNET):

Altı yığının dışında, verim bütünlüğünü sağlamak için iki yığın tutulur. Ancak yeni HBM3 standardı, çılgınca olan 3 TB/s hızlarında 80 GB’a kadar kapasiteye izin veriyor. Karşılaştırma için, mevcut en hızlı oyun grafik kartı RTX 3090 Ti, yalnızca 1 TB/s bant genişliği ve 24 GB VRAM kapasiteleri sunuyor. Bunun dışında, H100 Hopper GPU da en son FP8 veri biçiminde paketler ve yeni SXM bağlantısı aracılığıyla çipin etrafında tasarlandığı 700W güç tasarımına uyum sağlamaya yardımcı olur.

Bir Bakışta NVIDIA Hopper H100 GPU Özellikleri

Spesifikasyonlara gelince, NVIDIA Hopper GH100 GPU, toplam 8 GPC’de bulunan devasa bir 144 SM (Akış Çok İşlemcili) yonga düzeninden oluşur. Bu GPC’ler, her biri 2 SM biriminden oluşan toplam 9 TPC’yi sallar. Bu bize GPC başına 18 SM ve tam 8 GPC konfigürasyonunda 144 SM verir. Her SM, bize toplam 18.432 CUDA çekirdeği vermesi gereken 128 FP32 biriminden oluşur. H100 yongasından bekleyebileceğiniz yapılandırmalardan bazıları şunlardır:

GH100 GPU’nun tam uygulaması aşağıdaki birimleri içerir:

- 8 GPC, 72 TPC (9 TPC/GPC), 2 SM/TPC, tam GPU başına 144 SM

- SM başına 128 FP32 CUDA Çekirdeği, tam GPU başına 18432 FP32 CUDA Çekirdeği

- SM başına 4 Dördüncü Nesil Tensör Çekirdeği, tam GPU başına 576

- 6 HBM3 veya HBM2e yığını, 12 512 bit Bellek Denetleyicisi

- 60MB L2 Önbellek

- Dördüncü Nesil NVLink ve PCIe Gen 5

SXM5 kart form faktörüne sahip NVIDIA H100 GPU, aşağıdaki birimleri içerir:

- 8 GPC, 66 TPC, 2 SM/TPC, GPU başına 132 SM

- SM başına 128 FP32 CUDA Çekirdeği, GPU başına 16896 FP32 CUDA Çekirdeği

- SM başına 4 Dördüncü Nesil Tensör Çekirdeği, GPU başına 528

- 80 GB HBM3, 5 HBM3 yığını, 10 512 bit Bellek Denetleyicisi

- 50MB L2 Önbellek

- Dördüncü Nesil NVLink ve PCIe Gen 5

Bu, tam GA100 GPU yapılandırmasına göre 2,25 katlık bir artıştır. NVIDIA ayrıca Hopper GPU’su içinde performansı büyük ölçüde artıracak daha fazla FP64, FP16 ve Tensor çekirdeğinden yararlanıyor. Ve bu, aynı zamanda 1:1 FP64’e sahip olması beklenen Intel’in Ponte Vecchio’suna rakip olmak için bir gereklilik olacak.

Önbellek, NVIDIA’nın çok dikkat ettiği ve Hopper GH100 GPU’da 48 MB’a çıkardığı başka bir alandır. Bu, Ampere GA100 GPU’da bulunan 50 MB önbelleğe göre %20’lik bir artış ve AMD’nin amiral gemisi Aldebaran MCM GPU’su MI250X’in boyutunun 3 katı.

Performans rakamlarını özetleyen NVIDIA’nın GH100 Hopper GPU’su, FP8 için 4000 TFLOP, FP16 için 2000 TFLOP, TF32 için 1000 TFLOP ve FP64 Hesaplama performansı için 60 TFLOP sunacak. Bu rekor kıran rakamlar, kendisinden önce gelen tüm diğer HPC hızlandırıcılarını yok ediyor. Karşılaştırma için, bu NVIDIA’nın kendi A100 GPU’sundan 3,3 kat ve FP64 hesaplamasında AMD’nin Instinct MI250X’inden %28 daha hızlıdır. FP16 hesaplamasında, H100 GPU, A100’den 3 kat ve MI250X’ten 5,2 kat daha hızlıdır ki bu tam anlamıyla çılgındır.

Kısa bir süre önce Japonya’da 30.000 ABD Dolarının üzerinde bir fiyatla listelenmiş olan PCIe varyantı, daha güçlü bir konfigürasyona sahip SXM varyantının kolayca yaklaşık 50 bin dolara mal olacağını hayal edebilir.

NVIDIA Ampere GA100 GPU Tabanlı Tesla A100 Özellikleri:

| NVIDIA Tesla Grafik Kartı | NVIDIA H100 (SMX5) | NVIDIA H100 (PCIe) | NVIDIA A100 (SXM4) | NVIDIA A100 (PCIe4) | Tesla V100S (PCIe) | Tesla V100 (SXM2) | Tesla P100 (SXM2) | Tesla P100 (PCI Ekspres) |

Tesla M40 (PCI Ekspres) |

Tesla K40 (PCI Ekspres) |

|---|---|---|---|---|---|---|---|---|---|---|

| GPU’lar | GH100 (Bunker) | GH100 (Bunker) | GA100 (Amper) | GA100 (Amper) | GV100 (Volta) | GV100 (Volta) | GP100 (Paskal) | GP100 (Paskal) | GM200 (Maxwell) | GK110 (Kepler) |

| Süreç Düğümleri | 4nm | 4nm | 7nm | 7nm | 12nm | 12nm | 16nm | 16nm | 28nm | 28nm |

| transistörler | 80 Milyar | 80 Milyar | 54.2 trilyon | 54.2 trilyon | 21.1 Milyar | 21.1 Milyar | 15,3 Milyar | 15,3 Milyar | 8 Milyar | 7.1 Milyar |

| Kalıp Boyutlu GPU’lar | 814mm2 | 814mm2 | 826mm2 | 826mm2 | 815mm2 | 815mm2 | 610mm2 | 610mm2 | 601mm2 | 551mm2 |

| SMS’ler | 132 | 114 | 108 | 108 | 80 | 80 | 56 | 56 | 24 | 15 |

| TPC’ler | 66 | 57 | 54 | 54 | 40 | 40 | 28 | 28 | 24 | 15 |

| SM Başına FP32 CUDA Çekirdek Sayısı | 128 | 128 | 64 | 64 | 64 | 64 | 64 | 64 | 128 | 192 |

| FP64 CUDA Çekirdekleri / SM | 128 | 128 | 32 | 32 | 32 | 32 | 32 | 32 | 4 | 64 |

| FP32 CUDA Çekirdekleri | 16896 | 14592 | 6912 | 6912 | 5120 | 5120 | 3584 | 3584 | 3072 | 2880 |

| FP64 CUDA Çekirdekleri | 16896 | 14592 | 3456 | 3456 | 2560 | 2560 | 1792 | 1792 | 96 | 960 |

| Tensör Çekirdekleri | 528 | 456 | 432 | 432 | 640 | 640 | Yok | Yok | Yok | Yok |

| Doku Birimleri | 528 | 456 | 432 | 432 | 320 | 320 | 224 | 224 | 192 | 240 |

| Saati Yükselt | TBD | TBD | 1410MHz | 1410MHz | 1601 MHz | 1530MHz | 1480MHz | 1329MHz | 1114MHz | 875MHz |

| TOP’lar (DNN/AI) | 2000 TOP 4000 TOP |

1600 TOP 3200 TOP |

1248 TOP Seyreklik ile 2496 TOP |

1248 TOP Seyreklik ile 2496 TOP |

130 TOP | 125 TOP | Yok | Yok | Yok | Yok |

| FP16 Hesaplama | 2000 TFLOP | 1600 TFLOP | 312 TFLOP Seyreklik ile 624 TFLOP |

312 TFLOP Seyreklik ile 624 TFLOP |

32.8 TFLOP | 30,4 TFLOP | 21.2 TFLOP’lar | 18.7 TFLOP’lar | Yok | Yok |

| FP32 Hesaplama | 1000 TFLOP | 800 TFLOP | 156 TFLOP (19,5 tipik TFLOP) |

156 TFLOP (19,5 tipik TFLOP) |

16.4 TFLOP’lar | 15.7 TFLOP’lar | 10.6 TFLOP’lar | 10.0 TFLOP | 6.8 TFLOP’lar | 5.04 TFLOP |

| FP64 Hesaplama | 60 TFLOP | 48 TFLOP | 19.5 TFLOP (9,7 standart TFLOP’lar) |

19.5 TFLOP (9,7 standart TFLOP’lar) |

8.2 TFLOP’lar | 7.80 TFLOP | 5.30 TFLOP | 4.7 TFLOP | 0,2 TFLOP | 1.68 TFLOP |

| Bellek Arayüzü | 5120 bit HBM3 | 5120 bit HBM2e | 6144 bit HBM2e | 6144 bit HBM2e | 4096 bit HBM2 | 4096 bit HBM2 | 4096 bit HBM2 | 4096 bit HBM2 | 384 bit GDDR5 | 384 bit GDDR5 |

| Hafıza boyutu | 80 GB’a kadar HBM3 @ 3.0 Gbps | 80 GB’a kadar HBM2e @ 2.0 Gbps | 40 GB’a kadar HBM2 @ 1,6 TB/sn 80 GB’a kadar HBM2 @ 1,6 TB/sn |

40 GB’a kadar HBM2 @ 1,6 TB/sn 80 GB’a kadar HBM2 @ 2,0 TB/sn |

16 GB HBM2 @ 1134 GB/sn | 16GB HBM2 @ 900GB/sn | 16 GB HBM2 @ 732 GB/sn | 16 GB HBM2 @ 732 GB/sn 12 GB HBM2 @ 549 GB/sn |

24 GB GDDR5 @ 288 GB/sn | 12GB GDDR5 @ 288GB/sn |

| L2 Önbellek Boyutu | 51200 KB | 51200 KB | 40960 KB | 40960 KB | 6144 KB | 6144 KB | 4096 KB | 4096 KB | 3072 KB | 1536 KB |

| Pasifik yaz saati | 700W | 350W | 400W | 250W | 250W | 300W | 300W | 250W | 250W | 235W |