Nvidia, yapay zeka altyapısı ve yüksek performanslı bilgi işlem için tasarlanan yeni Grace CPU Superchip’i GTC 2022’de tanıttı.

Yeni 144 çekirdekli Arm Neoverse tabanlı ayrık veri merkezi CPU’su aslında şirketin yüksek hızlı, düşük gecikme süreli, çipten çipe (C2C) ara bağlantısı olan NVLink üzerinden bağlanan iki CPU çipinden oluşuyor.

Nvidia’nın Grace CPU Superchip’i, geçen yıl duyurulan Grace Hopper Superchip’i tamamlıyor ve bir taşıyıcı kartta bir CPU ve bir GPU’ya sahip. Yapıları farklı olsa da, her iki süper çip de aynı temel CPU mimarisini ve NVLink-CNC ara bağlantısını paylaşır.

Nvidia’nın kurucusu ve CEO’su Jensen Huang, bir basın bülteni Grace CPU Superchip’in AI iş yükleri için nasıl ideal olduğunu söyleyerek:

“Yeni bir veri merkezi türü ortaya çıktı – zeka üretmek için dağlarca veriyi işleyen ve iyileştiren yapay zeka fabrikaları. Grace CPU Superchip, en yüksek performansı, bellek bant genişliğini ve NVIDIA yazılım platformlarını tek bir yongada sunuyor ve dünyanın AI altyapısının CPU’su olarak parlayacak.”

Nvidia H100 ve DGX H100

Bir sonraki AI veri merkezleri dalgasını güçlendirmek amacıyla Nvidia, şirketin iki yıl önce başlatılan Nvidia Ampere mimarisinin yerini alan Nvidia Hoppper mimarisine sahip yeni nesil hızlandırılmış bilgi işlem platformunu da duyurdu.

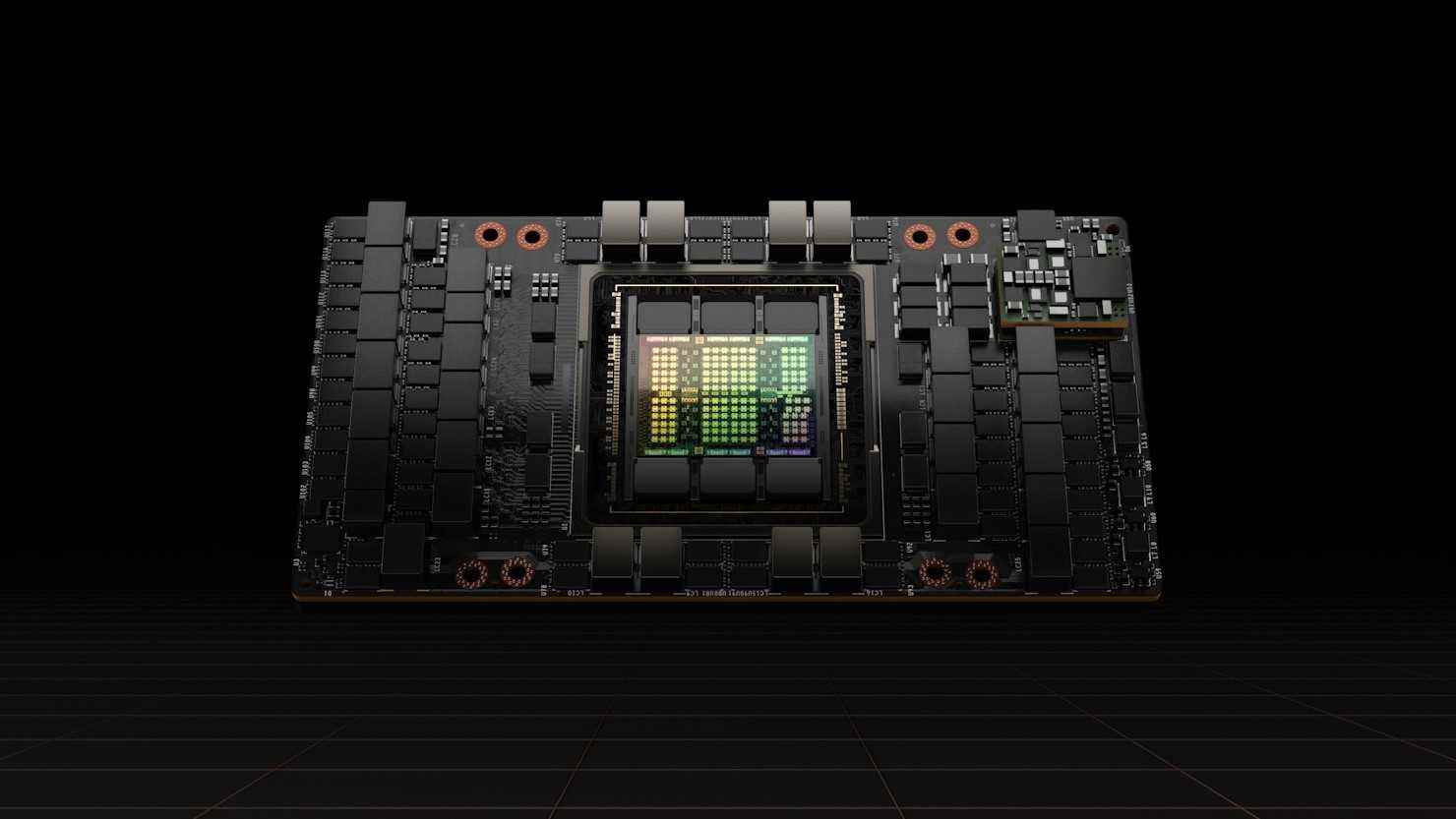

Yonga üreticisi, 80 milyar transistörle dolu ilk Hopper tabanlı GPU’sunu bile duyurdu. Nvidia H100, bugüne kadar dünyanın en büyük ve en güçlü hızlandırıcısıdır ve Grace CPU Superchip gibi, aynı zamanda devasa AI dil modellerini, derin öneri sistemlerini, genomikleri ve karmaşık dijital ikizleri geliştirmek için NVLink ara bağlantısına sahiptir.

Daha da fazla güç isteyen kurumsal işletmeler için Nvidia’nın DGX H100’ü (dördüncü nesil DGX sistemi) sekiz adet H100 GPU içerir ve yeni FP8 hassasiyetinde 32 petaflop yapay zeka performansı sunabilir. Bu, büyük dil modellerinin, öneri sistemlerinin, sağlık araştırmalarının ve iklim biliminin devasa bilgi işlem gereksinimlerini karşılayacak ölçeği sağlar. Nvidia’nın DGX H100 sistemlerindeki tüm GPU’ların 900GB/s bağlantı sağlamak için NVLink ile bağlı olduğunu belirtmekte fayda var.

Şirketin yeni Hopper mimarisi, önde gelen bulut bilişim sağlayıcılarından şimdiden geniş bir endüstri desteği aldı ve Alibaba Cloud, AWS, Baidu AI Cloud, Google Cloud, Microsoft Azure, Oracle Cloud ve Tencent Cloud, H100 tabanlı örnekler sunmayı planlıyor. Aynı zamanda Cisco, Dell Technologies, HPE, Inspur, Lenovo ve diğer sistem üreticileri, H100 hızlandırıcılı sunucuları piyasaya sürmeyi planlıyor.

Nvidia’nın H100 GPU’sunun bu yıl içinde dünya çapında bulut servis sağlayıcılarından, bilgisayar üreticilerinden ve doğrudan şirketin kendisinden temin edilmesi bekleniyor.