Büyük verilerin oluşmasıyla beraber, verilerin işlenmesi, kullanılması, depolanması, güvenirliği gibi temel sorunlar oluşmaya başlamıştı. Özellikle devasa veriler bulunduran arama motorları buna bir çözüm bulmak zorunda kalmışlardı. Google ilk olarak 2003 yılında kendi içerisinde oluşturmuş olduğu dağıtık mimarideki dosya sistemi olan GFS’yi (Google File System – Google Dosyalama Sistemi) duyurdu daha sonra veriler üzerinde uyguladığı yöntem olan MapReduce programlama modelini açıklayan çalışmasını yayınladı. Çalışmanın yayınlanmasıyla birlikte bilim çevreleri tarafından da takip edilen gelişmeler, özellikle dosyalama sisteminin dağıtık olması ve üzerinde MapReduce ile işlemlerin yapılmasının, büyük verilerle gelen sorunların çözümü açısından önemli bir gelişme olarak görüldü.

Doug Cutting’in ve Arkadaşlarının Katkısı

Yılların geçmesiyle beraber gelişmeleri takip eden Doug Cutting ve arkadaşları dağıtık dosyalama sistemini ve MapReduce uygulamasını Nutch adındaki arama motorunda kullanarak üst seviyede bir performans elde ettiler. Açık kaynak kodlu bu projeye HADOOP ismi verildi. Nucth arama motoru ve yeni geliştirilmiş olan HADOOP kütüphanesi Apache çatısı altında buluşmuştu. Diğer yandan GFS ismi de HADOOP isminin oluşmasıyla HDFS (Hadoop Distributed File System – Hadoop Dağıtık Dosyalama Sistemi) olarak değiştirildi.

Google X Yahoo

2006 yılında Doug Cutting’in Yahoo firmasıyla anlaşarak HADOOP projesinin ilk uygulamalarından birini, Yahoo sitesinde arama motoru oluşturarak gerçekleştirmiş oldu. Bu gelişmeyle beraber aynı zamanda arama motoru camiasında Yahoo ve Google rakip haline geldi.

HADOOP Çağına göre üst segmentte olmayan bilgisayarlar ile Cluster’lar (küme) oluşturarak, çok daha maliyetli ve yüksek özellikli bilgisayarlardan daha iyi performans sağlamaktaydı. Bu da Yahoo ve Google için en önemli tercih sebebi olmuştu.

İlk zamanlar sadece arama motorları ve veri barındıran büyük firmalar tarafından kullanılan HADOOP. Büyük verinin de yaygınlaşmasıyla günümüzde oldukça yaygın kullanılan bir proje haline gelmiştir.

HADOOP Cluster’ları eşzamanlı ve paralel çalışan yatay bir mimariden oluşmaktadır. İhtiyaç halinde yine üst segment olmayan maliyeti az olan bilgisayarlar ilave edilerek güçlendirilebilirler.

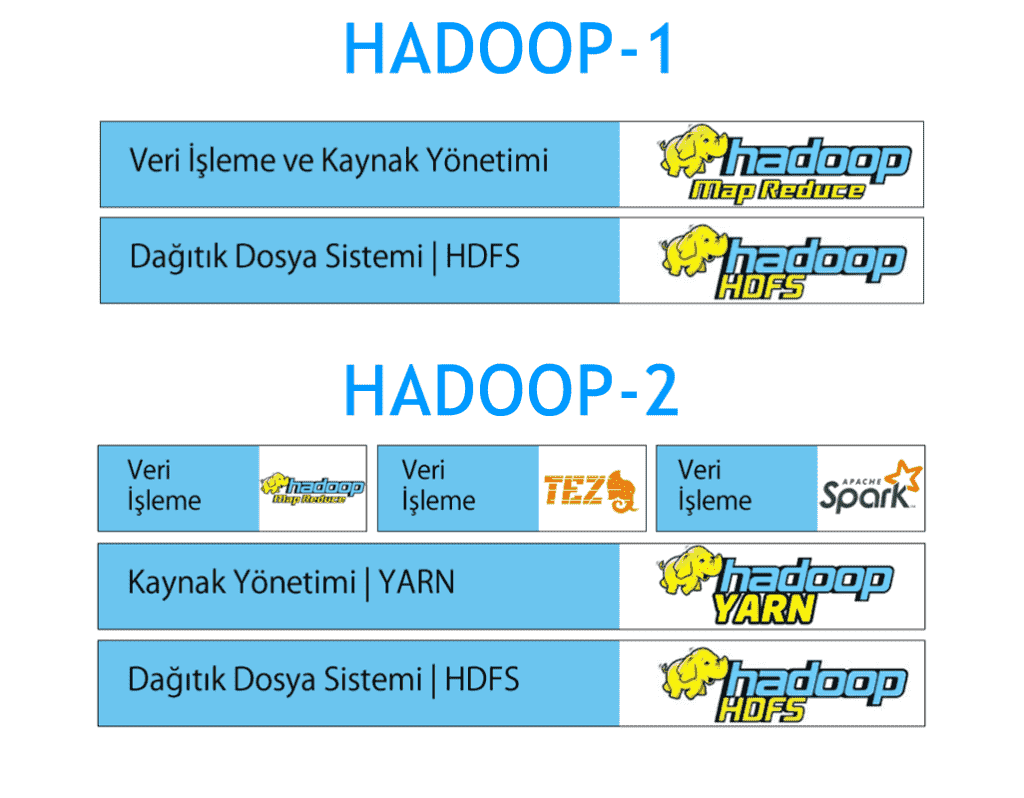

HADOOP-1 ve HADOOP-2 Temel Bileşenleri

HADOOP ilk ortaya çıkıp proje haline geldiğinde temel olarak 2 bileşenden oluşmaktaydı. HDFS ve MapReduce. Proje bu haliyle HADOOP-1 olarak anılmaktadır. HADOOP-1’de kaynak erişimi, verilerin işlenmesi, sonuçlarının çıkarılması gibi tüm işlemler MapReduce ile yapılmaktaydı. Daha sonra yine Apache yazılımcıları tarafından geliştirilen açık kaynak kodlu olan YARN uygulaması kaynak yönetimini MapReduce üzerinden alarak HADOOP’un performansını çok daha iyi duruma getirdi. YARN’ın geliştirilmesi ve projeye dahil edilmesi HADOOP-2 olarak isimlendirilmiştir.